来自DeepMind,大学学院和哈佛大学的一组研究人员发现,将学习技术应用于AI系统的经验教训可能有助于解释奖励途径如何在大脑中发挥作用。该小组在《自然》杂志上发表的论文中描述了将计算机中的分布强化学习与小鼠大脑中的多巴胺处理进行比较,以及他们从中学到的知识。

先前的研究表明,大脑中产生的多巴胺与奖赏过程有关-它是在发生好事时产生的,其表达会带来愉悦的感觉。一些研究还表明,大脑中对多巴胺的存在做出反应的神经元都以相同的方式做出反应-事件会使人或小鼠感觉好坏。其他研究表明,神经元反应更多是一个梯度。在这项新工作中,研究人员发现了支持后一种理论的证据。

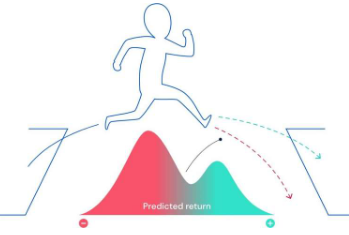

分布式强化学习是一种基于强化的机器学习。在设计诸如Starcraft II或Go之类的游戏时经常使用它。它会跟踪好动作与坏动作之间的关系,并学会减少坏动作的数量,并发挥更多的性能。但是,这样的系统不会对所有好的和坏的动作都一视同仁-每个动作在记录时都经过加权,权重是做出未来动作选择时所使用的计算的一部分。

研究人员指出,人类似乎也使用类似的策略来提高他们的游戏水平。伦敦的研究人员怀疑,人工智能系统与大脑进行奖励处理的方式之间的相似性也可能相似。为了确定它们是否正确,他们对小鼠进行了实验。他们将能够插入单个多巴胺神经元反应的设备插入大脑。然后,对小鼠进行培训以执行一项任务,在这些任务中,它们会以期望的方式获得奖励。

小鼠神经元反应表明,它们并非都像先前理论所预测的那样以相同的方式反应。取而代之的是,他们以可靠的不同方式做出反应-就像团队所预测的那样,表明小鼠所体验到的愉悦程度更多是一种梯度。

教育新闻网

教育新闻网