Google Cloud用户现在可以利用NVIDIA Ampere GPU的功能处理其AI工作负载。

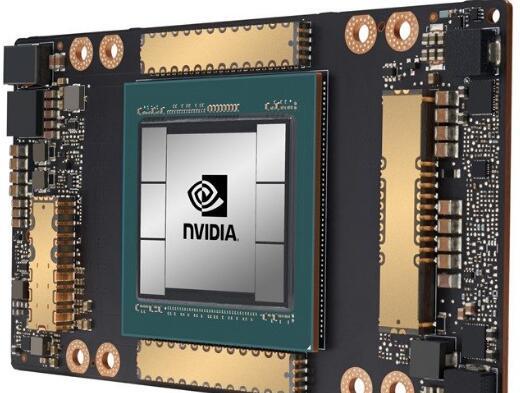

谷歌云中添加的特定GPU是上个月宣布的NVIDIA A100 Tensor Core。NVIDIA表示,A100“比历史上任何NVIDIA GPU更快地进入云计算。”

NVIDIA声称A100将训练和推理性能提高了20倍。在1,024架A100上,仅需37分钟即可训练BERT等大型AI模型。

对于那些享受以万亿浮点(TFLOPS)进行测量的人来说,A100可提供约19.5 TFLOPS的单精度性能和156 TFLOPS的Tensor Float 32工作负载。

Google Cloud产品管理总监Manish Sainani说:

“ Google Cloud客户经常希望我们提供最新的硬件和软件服务,以帮助他们推动AI和科学计算工作负载的创新。

与我们的NVIDIA T4 GPU一样,凭借我们新的A2 VM系列,我们很荣幸成为市场上第一批销售NVIDIA A100 GPU的主要云提供商。我们很高兴看到我们的客户将如何使用这些新功能。”

宣布的时机来得更好,除了气候变化等其他全球性挑战之外,许多人都希望利用AI来解决COVID-19大流行。

除了AI培训和推理外,客户还将能够通过新功能实现其他功能,包括数据分析,科学计算,基因组学,边缘视频分析和5G服务。

新的基于Ampere的数据中心GPU现在可以在Google Cloud的Alpha中使用。用户可以访问多达16个A100 GPU的实例,这些实例总共提供640GB的GPU内存和1.3TB的系统内存。

教育新闻网

教育新闻网