人工神经网络学习活动的高能耗是广泛使用人工智能(AI)的最大障碍之一,特别是在移动应用中。可以从有关人脑的知识中找到解决该问题的一种方法。

尽管它具有超级计算机的计算能力,但仅需20瓦,仅相当于超级计算机的能量的百万分之一。

原因之一是大脑神经元之间的信息有效传递。神经元向其他神经元发送短的电脉冲(尖峰),但为了节省能量,仅在绝对必要的时候才会发生。

基于事件的信息处理

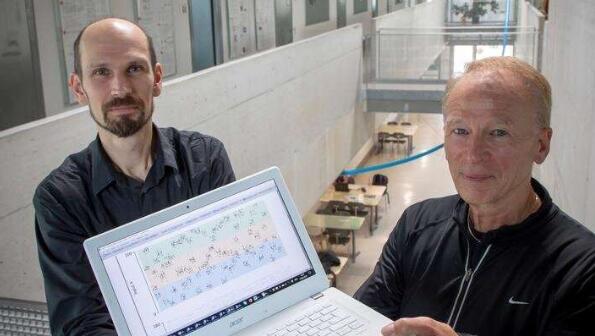

由TU Graz的两位计算机科学家Wolfgang Maass和Robert Legenstein领导的工作组在开发新的机器学习算法e-prop(e-propagation)时采用了这一原理。

也是欧洲灯塔项目“人脑计划”的一部分的理论计算机科学研究所的研究人员,使用模型中的尖峰信号在人工神经网络中的神经元之间进行通信。

尖峰仅在网络中的信息处理需要它们时才变为活动状态。对于这种不太活跃的网络,学习是一个特殊的挑战,因为需要更长的观察时间才能确定哪些神经元连接可以改善网络性能。

先前的方法学习成功率太低或需要巨大的存储空间。现在,E-prop通过从大脑复制的分散方法解决了这个问题,其中每个神经元在所谓的e-trace(合格跟踪)中记录何时使用其连接。该方法与最佳和最详尽的其他已知学习方法一样强大。详细信息现已发表在科学杂志《自然通讯》上。

在线而不是离线

使用当前使用的许多机器学习技术,所有网络活动都集中存储和脱机存储,以便跟踪每几个步骤在计算过程中如何使用连接。

但是,这需要在内存和处理器之间进行恒定的数据传输,这是当前AI实现过多能耗的主要原因之一。另一方面,e-prop可以完全在线运行,即使在实际操作中也不需要单独的内存,从而使学习更加节能。

神经形态硬件的驱动力

Maass和Legenstein希望e-prop将推动新一代移动学习计算系统的开发,该系统不再需要进行编程,而是根据人脑模型进行学习,从而适应不断变化的需求。

目标是不再让这些计算系统专门通过云来学习大量能源,而是将大部分学习能力有效地集成到移动硬件组件中,从而节省能源。

已经采取了将e-prop引入应用程序的第一步。例如,TU Graz团队正在与曼彻斯特大学的高级处理器技术研究小组(APT)合作开展人脑项目,以将e-prop集成到在那里开发的神经形态SpiNNaker系统中。同时,格拉茨大学(TU Graz)正在与半导体制造商英特尔的研究人员合作,将算法集成到英特尔神经形态芯片Loihi的下一个版本中。

这项研究工作扎根于格拉茨TU的五个专业领域中的两个,即“人类与生物技术”和“信息,通信与计算”专业领域。

教育新闻网

教育新闻网